Algoritmilor IA bazați pe învățarea automată le lipsește transparența. Organizațiile umane care decid să automatizeze luarea deciziilor ar trebui să fie obligate din punct de vedere legal să demonstreze capacitatea de a explica și justifica deciziile algoritmice care au un impact asupra bunăstării, drepturilor, și oportunitățile celor afectați de decizii. Această obligație legală poate fi derivată din cerințele rațiunii publice rawlsiene. Argumentul de la limitările cogniției umane nu reușește să scoată IA de sub rațiunea publică. Împotriva unei tendințe în creștere în etica IA, analogia dintre mințile umane și rețelele neuronale artificiale eșuează, deoarece suferă de o prejudecată atomistă care o face oarbă față de dimensiunea socială și instituțională a proceselor de raționament uman. Dezvoltarea algoritmilor interpretativi IA nu este singurul răspuns posibil la problema explicabilității; sunt disponibile și răspunsuri sociale și instituționale și în multe cazuri mai demne de încredere decât cele tehnoștiințifice.

Este recunoscut pe scară largă faptul că implementarea sistemelor de inteligență artificială bazate pe învățarea automată în toate sferele vieții umane aduce cu sine o serie de dileme etice spinoase de care se ocupă acum cercetătorii și factorii de decizie politică. Beneficiile potențiale ale delegării sarcinilor îndeplinite până acum de oameni către algoritmii IA trebuie să fie cântărite în raport cu diferitele riscuri etice care vin cu o astfel de delegare. De exemplu, deciziile automate pot fi părtinitoare în mod sistematic împotriva unei anumite clase de oameni (O’Neil, 2016; Chander, 2017; West et al., 2019). Cum să alocați responsabilitatea pentru deciziile sau actele automate care provoacă prejudicii, rămâne o întrebare (Floridi, 2016). Algoritmii IA ne pot invada confidențialitatea deducând informații despre aspecte ale noastre pe care nu am dorit să le dezvăluim prin corelarea punctelor de date care nu sunt considerate legal informații personale (Wachter & Mittlestadt, 2019). Chiar și cei care susțin o viziune nuanțată și prudentă asupra capacităților IA și a impactului previzibil asupra vieții umane cred că noul val de automatizare care va fi activat de IA ar putea exacerba inegalitățile existente (James, 2020).

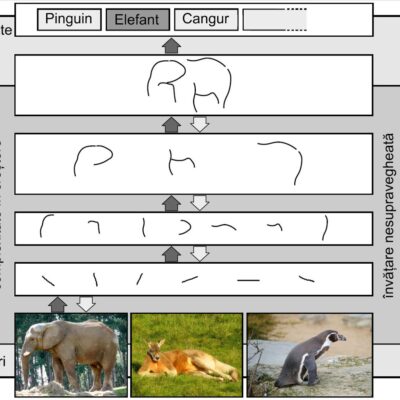

O altă problemă larg recunoscută ridicată de utilizarea sistemelor socio-tehnice bazate pe IA este cauzată de lipsa de transparență a acestora.Trecerea de la programarea „simbolică” bazată pe reguli la învățarea automată a îmbunătățit dramatic rata de succes a mai multor programe IA, în special în domenii precum viziunea computerizată și procesarea limbajului natural (LeCun et al., 2015). Dar precizia sporită a venit cu prețul opacității: înțelegerea motivelor sau cauzelor care explică de ce un sistem IA x a decis că y este decizia sau cursul corect de acțiune nu este, în general, posibilă. Aceasta este ceea ce se numește acum, adesea interschimbabil, problema „cutiei negre” a IA, „explicabilitate”, „transparență”, „interpretabilitate” sau „inteligibilitate” (Burrell, 2016; Weller, 2017; Selbst & Powles, 2017; Doshi- Velez & Kim, 2017; Mittlestadt et al., 2019). În consecință, majoritatea orientărilor etice la nivel înalt care au fost elaborate în ultimii ani includ explicabilitatea sau transparența printre valorile care ar trebui să stea la baza dezvoltării și implementării sistemelor IA (Jobin et al., 2019). Pentru a lua doar două exemple, Regulamentul general al UE privind protecția datelor (GDPR) și Directiva Guvernului Canadei privind luarea automată a deciziilor se referă la dreptul de a primi „informații semnificative” despre deciziile automatizate (consultați calificările din Selbst & Powles, 2017). ). Așa cum stau lucrurile, acest angajament general față de explicabilitate rămâne abstract, și multe voci puternice din cadrul IA pledează pentru o slăbire – dacă nu pentru abandonarea – cerinței de explicabilitate.

Aplicarea legală a unei cerințe puternice de explicabilitate: organizațiile umane care decid să automatizeze luarea deciziilor ar trebui să fie obligate din punct de vedere legal să demonstreze capacitatea de a explica și justifica deciziile algoritmice care au un impact asupra bunăstării, drepturile și oportunitățile celor afectați de decizii. Această obligație legală poate fi derivată din cerințele rațiunii publice rawlsiene. Argumentul de la limitările cogniției umane nu reușește să scoată IA din cârligul rațiunii publice. Împotriva unei tendințe în creștere în etica IA, Analogia dintre mințile umane și rețelele neuronale artificiale eșuează, deoarece suferă de o părtinire atomistă care o face oarbă față de dimensiunea socială și instituțională a raționamentului uman și luarea deciziilor.Dezvoltarea algoritmilor interpretativi IA nu este singurul răspuns posibil la problema explicabilității; sunt disponibile și răspunsuri sociale și instituționale și în multe cazuri mai demne de încredere decât cele tehnoștiințifice.

Sursa: Maclure, J. AI, Explainability and Public Reason: The Argument from the Limitations of the Human Mind. Minds & Machines 31, 421–438 (2021). https://doi.org/10.1007/s11023-021-09570-x, licența CC BY 4.0. Traducere și adaptare © 2023 Nicolae Sfetcu

Lasă un răspuns